La ciencia, en su búsqueda de la verdad, conjuga procesos de descubrimiento con métodos de investigación que producen conocimiento teórico en diversos formatos. La aplicación de este conocimiento como herramienta transformadora tiene el potencial de mejorar la vida humana en diversos campos, pero también el de generar daños colaterales, dilemas sociales complejos e impactos ambientales. Reflexionar sobre la ética de una ciencia particular implica interrogarse no sólo acerca del contexto y medios para la obtención de ese conocimiento, sino también sobre los límites del mismo y las responsabilidades que emergen del desarrollo y aplicación de ese saber. En este sentido, la ética científica actúa como un marco orientador que busca orientar a que la investigación y sus aplicaciones se alineen con valores fundamentales como la integridad, la equidad y el bien común.

En disciplinas noveles como la inteligencia artificial, donde los desafíos técnicos son profundos y las fronteras del conocimiento aún se encuentran en construcción, existe una tendencia a identificar la propuesta de discusión teorética –o incluso epistemológica– como equivalente o como parte de los aspectos éticos de la materia cuando en realidad, muy por el contrario, se busca profundizar en el quid est de la IA como pregunta primera y necesaria que precede toda valoración axiológica. Esta “fuga a la ética” suele dejar de lado los problemas científicos de fondo e inclinar el debate hacia cuestiones prácticas “más accesibles”. Sin embargo, enfocarse en ciertos dilemas éticos sin un sólido planteo teórico –que incluso explicite los desafíos técnicos que persisten como obstáculos no resueltos– resulta un intercambio de “discursos” que poco favor hacen a una ética real.

En este sentido, Nick Bostrom sostiene que el desarrollo de la inteligencia artificial general (AGI) o de sistemas que verdaderamente emulen la inteligencia humana sigue siendo un desafío pendiente por lo que numerosos debates “éticos” se adelantan a cuestiones técnicas aún no resueltas. A pesar de los avances en aprendizaje profundo (DL), redes neuronales artificiales (ANN) y procesamiento del lenguaje natural (NLP), los problemas de inteligencia, intencionalidad y sentido común permanecen como áreas de investigación opacas y de progreso lento.

Frente a esta dificultad, algunos teóricos tienden a desplazarse hacia el ámbito ético de la IA, donde las discusiones suelen ser más especulativas y no requieren validación empírica rigurosa.

Stuart Russell destaca que, si bien el estudio de la ética de la IA es valioso, en ocasiones puede eclipsar cuestiones más apremiantes relacionadas con el control técnico de los sistemas. En lugar de abordar desafíos concretos, como la optimización de algoritmos o la resolución de problemas de alineación, la reflexión ética permite a los teóricos explorar dilemas abstractos sin la presión de obtener resultados tangibles. Debates en torno a “los derechos de los robots” o “la conciencia artificial” representan, en este sentido, una vía de escape intelectual ante la complejidad inherente a la mejora de sistemas que aún enfrentan dificultades en tareas básicas de razonamiento y planificación. Luciano Floridi subraya que gran parte de la ética de la IA se basa en analogías antropomórficas que, aunque atractivas, no abordan los problemas técnicos reales del campo. Los divulgadores de la IA, influenciados por narrativas populares, tienden a proyectar cualidades humanas en la IA, atribuyéndole intenciones y valores. Esta tendencia a la antropomorfización deriva en debates éticos sobre escenarios hipotéticos –como una rebelión de las máquinas–, que resultan más atrayentes que el análisis de las limitaciones inherentes a los modelos actuales de representación o de aprendizaje por refuerzo.

Además, muchos de estos debates éticos carecen del rigor técnico necesario y se centran en escenarios futuristas en lugar de abordar los desafíos inmediatos. El discurso en torno a la IA, influenciado por narrativas culturales y de ficción científica, suele inclinarse hacia dimensiones especulativas, dejando en segundo plano los problemas estructurales reales. Las cuestiones éticas capturan con mayor facilidad la atención mediática en comparación con los debates estrictamente técnicos.

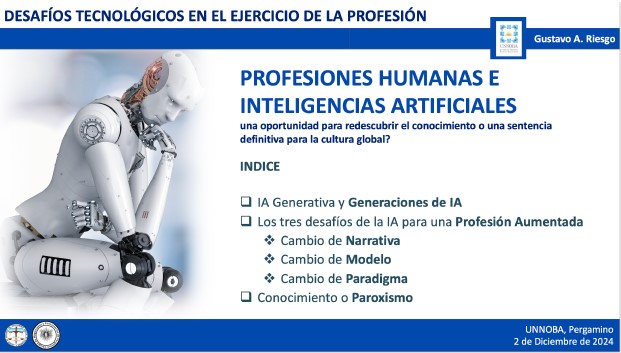

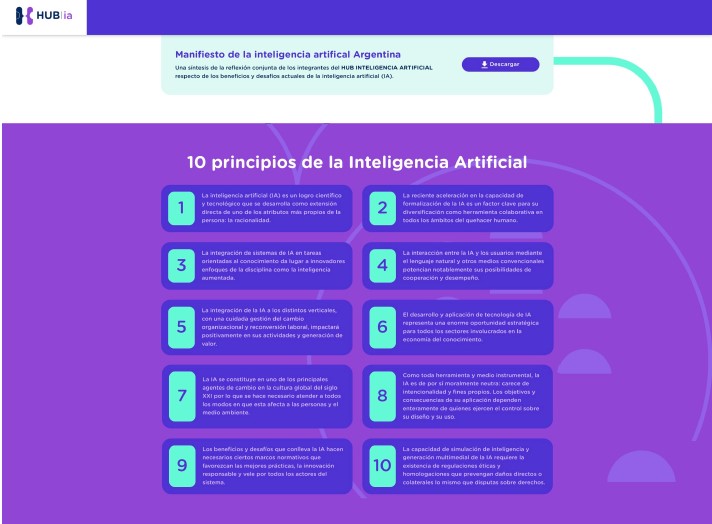

El desarrollo de una Ética de la Inteligencia Artificial con entidad propia es fundamental para garantizar una visión humanística de la IA y favorecer una innovación responsable. Su campo de acción tiene una consideración primaria: que se arbitren todos los esfuerzos y medios técnicos disponibles para que las IAs respondan a criterios de gobernabilidad, explicabilidad, trazabilidad y transparencia. En ese contexto, también es necesario considerar que toda la potencia real de las IAs, si es usada para acciones perjudiciales o delictivas como el cibercrimen, puede resultar en enormes daños morales y materiales. Es debido a esto que cierta regulación de las IAs, es decir: cuerpos normativos legales de aplicación y cumplimiento para determinadas operaciones que involucran procesos con inteligencias artificiales, son una necesidad más temprano que tarde. Igualmente, este es un tema de amplio espectro que comprende desde geopolítica y soberanía de las naciones hasta la protección de datos, de la propiedad de entidades y de la privacidad de los individuos y de sus personas digitales. La UE ha dado pasos firmes al respecto, quizás un tanto restrictivos y sólo basados en protocolos de evaluación de riesgo. Otros países y comunidades han avanzado en distinta dirección, como USA – aunque falta ver las definiciones por cada Estado–, mientras el tema se encuentra en debate abierto.

En colaboración con: